Investigare su immagini e video

La crescente diffusione di dispositivi di imaging a basso costo e la conseguente disponibilità di grosse quantità di foto e filmati digitali, rende l’attività investigativa e di verifica e di analisi su tali tipologie di dati sempre più frequente. A tale scopo risulta fondamentale riuscire ad individuare con precisione le modalità di repertazione scientifica di questa specifica tipologia di “informazione” per non lasciare nulla di intentato nella ricerca di fonti di prova spesso decisive. Le potenzialità indotte dall’uso consapevole delle informazioni contenute in un segnale digitale (immagine/video, ecc.) sono notevoli a patto però di conoscere i fondamenti tecnici di base della disciplina. L’Image Forensics comprende tutte le attività di analisi delle immagini (e dei video) svolte oramai prevalentemente in ambito digitale, volte ad estrapolare dati e informazioni ad uso forense.

Con il termine Image (Video) Forensics ci si riferisce ad una specifica area della Digital Forensics [1, 2] che si occupa dello studio e dell’analisi di immagini (e di video) per la loro validazione e utilizzo in ambito forense. Questa disciplina, che ha visto la luce negli ultimi anni del secolo scorso e la cui continua evoluzione segue i ritmi incalzanti dello sviluppo tecnologico odierno, può essere a sua volta divisa in diversi filoni specifici quali ad esempio:

Forgery Identification: si occupa di identificare presunte manipolazioni, ovvero di inserimento o di cancellazione di particolari per fini fraudolenti (es. alibi, contraffazione, ecc.) in contesti eterogenei [3, 4];

Source Identification: individuazione della sorgente che ha generato l’immagine, sia dal punto di vista fisico e quindi del modello/tipologia di apparecchiatura (scanner, fotocamera, smartphone, ecc) che dal punto di vista software (si pensi alle applicazioni native tipiche di alcune app installate sugli smartphone che sono orientate alla pubblicazioni e allo sharing tramite piattaforme legate ai Social Network (esempio Facebook, Twitter, ecc.) [4, 5, 6].

Enhancement/Reconstruction: restauro e/o miglioramento di immagini/video deteriorati al fine di identificare, anche parzialmente, il contenuto originale e/o recuperare informazioni [7].

Video Analysis: analisi di situazioni complesse caratterizzata da elementi di dinamicità volte ad esempio ad individuare dinamiche e/o comportamenti sospetti di veicoli o soggetti, spesso utilizzando fonti multiple e dove assume un ruolo fondamentale anche la procedura di acquisizione delle fonti da analizzare [7, 8].

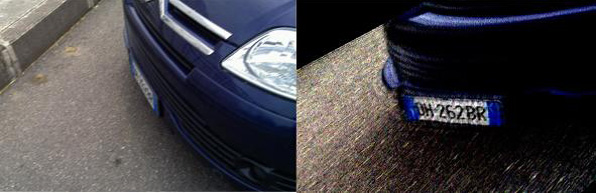

Sebbene i primi due settori abbiano assunto particolare rilevanza nella comunità scientifica di riferimento, nondimeno gli altri ambiti sono ugualmente rilevanti sia nel campo della sicurezza (es. Video Sorveglianza) che a fini investigativi, in ambiti più tradizionali, ove risulta necessario mettere in evidenza particolari ed informazioni contenute nell’immagine. Come ampiamente evidenziato in [9], tali metodologie di analisi possono essere usate per estrarre le relative evidenze forensi solo se l’informazione è effettivamente presente e (sia pur in maniera labile e appena accennata come evidenziato ad esempio in Figura 1), ma non possono “inventarsi” dei dati di qualsiasi natura qualora questi non ci siano. Un esempio in questo senso (purtroppo ancora molto frequente) riguarda immagini acquisite da dispositivi di videosorveglianza, che, pur registrando l’evento criminoso, risultano inutilizzabili a causa della scarsa qualità del sistema di ripresa (scarsa risoluzione, rumore, ecc.). A tal proposito segnaliamo l’interessante studio di Ashby [10], pubblicato nel 2017, che riporta le statistiche di utilizzo e di effettiva utilità nelle indagini di immagini catturate da sistemi di videosorveglianza in un periodo temporale di 5 anni all’interno del sistema dei trasporti britannico.

Fondamenti di Elaborazione delle Immagini

Le immagini digitali possono essere rappresentate come un segnale discreto bidimensionale (e cioè rappresentabile mediante dei numeri finiti e con una certa precisione detti pixels) in grado di replicare la sensazione percettiva legata alla visione di una scena reale. Diversamente da una macchina fotografica tradizionale, una fotocamera digitale utilizza, al posto della pellicola, un sensore costituito da milioni di elementi fotosensibili in grado di catturare l’immagine e trasformarla in un segnale elettrico di tipo analogico. Gli impulsi elettrici catturati dal sensore, la cui intensità varia a seconda della luce che colpisce il singolo fotorecettore, vengono convertiti e trasformati in un flusso di dati digitali. Questo procedimento è detto campionamento spaziale e determina la cosiddetta “risoluzione” degli apparati di acquisizione, che viene solitamente misurata in MegaPixels.

All’aumentare della risoluzione corrisponde una migliore accuratezza nella rappresentazione dei dettagli. Prima che la luce della scena fotografata raggiunga il sensore, essa attraversa un sistema di lenti e di filtri che consente ad ogni pixel di catturare informazioni riguardanti ciascuna delle tre componenti di colore (rosso-verde-blu) in cui la luce della scena da acquisire viene scomposta. Nel passo successivo, per ricostruire il colore originale, il software interno della fotocamera ricalcola le componenti primarie su ogni pixel usando varie strategie ed algoritmi (interpolazione del colore o demosaicing, bilanciamento del bianco, correzione gamma) e vari altri metodi di ottimizzazione del colore. Infine l’immagine digitale è salvata sul dispositivo di memorizzazione della fotocamera nel formato selezionato dall’utente (tipicamente il JPEG) con opportuni parametri di compressione.

I video digitali sono una naturale generalizzazione e possono essere definiti o come un segnale discreto che attua un campionamento temporale della scena reale (ovvero ad ogni istante la scena è “fotografata”) oppure attraverso la successione di istantanee appositamente composte. Tale sequenza è quindi costituita da una serie di frame, cioè dalle singole immagini che compongono il video, dette anche fotogrammi. Oltre che dalla necessità di contenere le dimensioni dei dati, al fine sia di memorizzarli che di trasmetterli, la compressione nel caso di sequenze video trae origine dalla necessità di garantire la riproduzione delle sequenze in maniera adeguata. Il framerate o frame (o immagini) per secondo, è l’unità di misura della frequenza di visualizzazione delle singole immagini che compongono il video. I parametri fondamentali da tenere in considerazione in quanto consentono (o meno) all’analista di estrarre le relative evidenze forensi sono: la risoluzione spaziale (che corrisponde al livello di dettaglio), il framerate (l’unità di misura della frequenza di visualizzazione delle singole immagini) ed il livello di compressione.

Come già accennato uno dei temi sicuramente più rilevanti del settore riguarda il trattamento e la verifica di autenticità di reperti multimediali.

Contrariamente a quanto si può immaginare, i primi esempi documentati di manipolazione delle immagini risalgono al 1860, cioè solo pochi decenni dopo la nascita della fotografia. A differenza di allora, la cui esecuzione era ad esclusivo appannaggio di pochissimi esperti, con l’avvento delle fotocamere digitali, videocamere e sofisticati software di editing fotografico, la manipolazione di immagini digitali sta diventando sempre più un’operazione alla portata dell’utente comune. Prima dell’avvento della fotografia digitale, molto raramente veniva messa in dubbio l’autenticità di una immagine presentata come fonte di prova in un procedimento giudiziario. Nel caso in cui fosse stato necessario corredare un fascicolo di indagine delle relative fotografie, era comunque prassi depositare anche la pellicola da cui queste provenivano, i cosiddetti negativi. In realtà anche questi ultimi potevano essere alterati, sia agendo fisicamente sulla pellicola asportando od aggiungendo alcune parti e poi sviluppando l’immagine dal negativo modificato, oppure duplicando il negativo con una apposita strumentazione dopo avere applicato opportune maschere atte a nascondere od inserire i particolari voluti. In entrambi i metodi però, le modifiche erano rilevabili da un occhio esperto: nel primo caso era sufficiente esaminare il negativo modificato per notare i ritocchi, nel secondo si sfruttavano le diverse caratteristiche (grana, spessore) del negativo-copia, che per motivi tecnici non erano mai uguali a quelli dei rullini delle fotocamere.

Rispetto al contesto analogico, in cui l’immagine “si forma stabilmente” sulla pellicola, nelle odierne fotocamere l’informazione sulla scena “transita” nel sensore (l’analogo funzionale della pellicola) prima di essere salvata nella memoria di massa decisa dall’utente. Negli apparati digitali nulla vieta all’operatore di cancellare in tempo reale l’immagine appena scattata, se questa non lo soddisfa, dopo averla preliminarmente visionata sul display o addirittura agire sulla memoria di massa successivamente allo scatto per alterare o sostituire il contenuto originario. Per un confronto approfondito tra vecchi e nuovi metodi di “forgery” si vedano [11,12].

Accertare l’integrità di una immagine o di un video rappresenta un compito notevolmente più difficile di un tempo: non vi sono segni su un negativo o spessori di pellicole da controllare, ma una quantità enorme di dati, che vanno interpretati valutandone anche il grado di attendibilità. Bisogna innanzitutto ricostruire la cosiddetta catena di custodia (chain of custody) al fine di garantire la non alterabilità dei dati come pre-requisito indispensabile alla accettazione di qualsiasi fonte di prova. Inoltre, è fondamentale l’analisi dei metadati: informazioni contenute nello stream del file in cui sono riportati, tra gli altri, la data di creazione, le impostazioni della macchina al momento di riprendere la scena, eventuali miniature delle immagini (thumbnail) ed in taluni casi le coordinate GPS della posizione della camera al momento dello scatto. I metadati (es. EXIF, XMP, ecc.), possono essere utilizzati per isolare evidenze investigative, per verificare eventuali inconsistenze con le informazioni visive nelle immagini (es, una scena notturna associata ad un’orario di ripresa diurno) e per evidenziare alcune manipolazioni, anche se un utente esperto potrebbe modificarli/alterarli mediante appositi software. Infine, nel caso in cui si utilizzi apparati di fascia medio/alta, è possibile che questi forniscano la possibilità di imprimere sulle immagini i cosiddetti watermark: piccoli “timbri” digitali la cui presenza (o assenza) può essere utile per validare una immagine. È possibile infine sfruttare metodi analitici che derivano direttamente dalla teoria dell’elaborazione della immagini. È il caso ad esempio della ricerca delle tracce lasciate dalla doppia quantizzazione, uno dei metodi “format based” descritti in dettaglio in [13]. Nel caso del formato compresso JPEG, che copre più del 90% delle immagini in circolazione, l’immagine prima di essere memorizzata subisce una compressione, in parte dovuta al processo di “quantizzazione” a cui è sottoposta [14,15,16].

L’European Network of Forensic Science Institutes (ENFSI) [17] organismo internazionale cui afferiscono le forze di polizia europee sta prendendo in considerazione la possibilità di produrre un BPM (Best Practice Manual) per poter fornire una guida di riferimento agli addetti ai lavori, che si trovano sempre più spesso a dover rispondere a quesiti tecnici incentrati proprio su queste tematiche.

Nel seguito riportiamo un dettaglio analitico delle varie tecnologie a disposizione dell’analista forense.

Identificazione della sorgente

Quando il sensore acquisisce una scena, anche nelle migliori condizioni di illuminazione, l’immagine digitale mostrerà comunque piccole variazioni di intensità tra i singoli pixel, a causa delle numerose fonti di rumore che intervengono nel processo di formazione dell’immagine. Tale rumore e’ composto da una componente casuale che dipende dal photon shot noise, rumore termico, ecc., e una componente fissa, dovuta al pattern noise, che lascia una traccia pressoché identica su tutte le immagini acquisite con lo stesso sensore. Il pattern noise si presta dunque ad essere usato per l’identificazione della fotocamera. In particolare, ogni fotocamera digitale possiede un sensore lievemente differente dalle altre dello stesso modello, per via di un “disturbo” univoco e riconoscibile, ciò permette di identificare il sensore a partire dalle immagini, sfruttando la stessa idea che ci consente di distinguere le tracce univoche lasciate dalle canne delle armi da fuoco sui proiettili. Il disturbo generato nelle immagini è legato sia al sensore in sé, che alle minuzie nella costruzione e nell’assemblaggio di ogni dispositivo. Questo assicura una differenza tra singoli dispositivi sufficiente a rendere improbabile la presenza di due camere che generino il medesimo disturbo, proprio come avviene per le impronte digitali.

La questione si complica quando le immagini subiscono alterazioni di vario genere a seguito di processamenti da parte di applicativi software. E’ stato ormai dimostrato come la Camera Source Identification basata su “Pattern Noise”, non risulta essere sufficientemente valida su immagini elaborate anche con semplici editing (quali rescaling, cropping, ecc.) attraverso software di pubblico dominio quali ad esempio Photoshop o GIMP. Inoltre, le operazioni di ricodifica che vengono operate a valle, da uno qualunque di tali software, alterano pesantemente i valori del PRNU compromettendone l’efficacia [4]. Oggi, i Social Network consentono ai loro utenti di caricare e condividere un’enorme quantità di immagini: basti pensare che quotidianamente, si stima che su Facebook vengano caricate più di 300 milioni di immagini. Si definisce “Social Image Forensics” lo studio delle caratteristiche intrinseche delle immagini, pubblicate su un Social Network, al fine di identificare una sorta di “fingerprint” che tiri fuori delle evidenze, chiare e documentabili, tali da ricostruirne la “storia digitale” dell’immagine fin dall’acquisizione. Lo studio delle tematiche della “Social Image Forensics” è molto utile sia a scopo forense che investigativo: conoscere l’origine di una determinata immagine può infatti essere determinante in molti contesti. Le procedure di condivisione di dati ed in particolare di immagini digitali sulle piattaforme Social, introducono vari e diversi processi di editing già durante il processo di upload. Queste vere e proprie alterazioni sono principalmente attuate al fine di ridurre lo spazio fisico di archiviazione o ancora lo spreco di banda necessario per il trasferimento o per la fruizione da parte degli utenti finali. Tutto ciò fa decadere del tutto la cosiddetta integrità del file e rende ancora più complessa la fase di ricostruzione della storia dell’immagine, fino a distruggere del tutto ogni informazione sull’acquisizione originaria.

Risulta altresì chiaro come tali alterazioni dipendano da una molteplicità di fattori legati sia alla specifica piattaforma Social, su cui si realizza il caricamento dell’immagine, che alle caratteristiche delle immagini in termini di contenuto e di risoluzione. Si consultino [5,6] per ulteriori approfondimenti.

Identificazione delle Contraffazioni

Le tecniche utilizzate per individuare le manipolazioni (o forgery) si dividono essenzialmente in due categorie: metodi attivi e passivi. I metodi attivi prevedono l’inserimento di una segno distintivo (una sorta di “firma” detta anche watermarking digitale) nel dato digitale al momento della relativa acquisizione da parte del dispositivo. Uno dei problemi di tale approccio è costituito dalla difficoltà di inserimento in modo univoco in tutti i dispositivi esistenti mediante uno standard unico, oltre al fatto che tali “firme” si sono dimostrati poco resistenti a tentativi di rimozione fraudolenta. Al contrario, i metodi passivi sfruttano le alterazioni del contenuto statistico dell’immagine provocate dalle contraffazioni, e a sua volta si suddividono in:

- Tecniche pixel-based: che individuano anomalie statistiche a livello di pixels;

- Tecniche format-based: che fanno leva sulle correlazioni statistiche contenute nelle tecniche di compressione “lossy” (con perdita di dati);

- Tecniche camera-based: che sfruttano gli artefatti introdotti in generale dall’hardware o dal software che interviene durante le varie fasi della formazione dell’immagine;

- Tecniche physically-based: che mettono in evidenza le incoerenze tra le caratteristiche fisiche delle immagini reali ed i modelli fisico-matematici che li riproducono;

- Tecniche geometric-based: che sfruttano le nozioni della teoria della formazione dell’immagine per confrontare misure fisiche di oggetti reali e le loro posizioni rispetto alla fotocamera.

Casi di studio ed esempi pratici

Tra i molti episodi in cui i metodi di cui sopra sono state utilizzati come strumenti di indagine, appare sicuramente degno di nota il caso della “mozzarella blu”: nel 2010 alcune mozzarelle in vendita presso la grande distribuzione, all’apertura della confezione presentavano una colorazione bluastra a chiazze, causata da alcune anomalie nel processo di produzione e dalla presenza di un batterio. Il sequestro del prodotto in tutti i punti vendita italiani ha dato al caso una risonanza mediatica oltremodo rilevante.

Come conseguenza dell’episodio, si è assistito in rete al proliferare di immagini riproducenti mozzarelle colorate con le più svariate tonalità. Come ancora oggi è possibile verificare effettuando una ricerca sul web con le parole chiave “mozzarella blu”, numerose immagini provengono da alterazioni artificiose delle componenti “cromatiche” della medesima foto, con il chiaro intento di enfatizzare il messaggio codificato nell’immagine. Mediante l’ispezione di alcune caratteristiche di base delle immagini, ad esempio il loro istogramma si sono messe in evidenza le numerose manipolazioni e, tramite l’acquisizione “forense” dei dati nei siti in cui erano presenti le immagini, si è individuata anche la presunta fonte di prova inquinata iniziale [7]. Bisogna quindi riflettere anche sull’interpretazione semantica del termine “alterazione”: non si tratta solo di “togliere” o “aggiungere” particolari all’immagine (o al video), ma anche di modificarne i valori di luminosità o di colore, allo scopo di alterarne l’aspetto e quindi il messaggio associato alla fruizione della stessa. Citiamo a tal proposito un recente caso [18] riguardante le “alterazioni” che avrebbe subito l’immagine vincitrice del premio “World Photo Press 2012”. In merito all’ammissibilità, ed in genere all’utilizzo in dibattimento di fonti di prova costituite da immagini e video, è sicuramente interessante quanto riportato a proposito dell’”ammissibilità e regole di valutazione per immagini” relative ai fatti del G8 svoltosi a Genova nel 2001 [19] dove il collegio replica alle obiezioni sull’utilizzo di fonti di prova, costituite da filmati che a dire della difesa non sarebbero ammissibili in quanto “formati dalla giustapposizione di materiale vario, selezionato e montato […]” sottolineando come questo non basti a determinare la loro non utilizzabilità, “fatte salve la possibilità per le altre parti di addurre elementi idonei a dimostrare eventuali difetti di genuinità e manipolazioni arbitrarie delle immagini stesse.”

Per una più completa casistica sul tema si rimanda al video di una mia recente intervista pubblicata su CorriereTV [20] in cui si riportano ben 10 casi e a quanto riportato in [21] dove si discute dell’utilizzo di immagini e video ad-hoc per inscenare falsi alibi.

Conclusioni

Le tecniche di Image / Video Forensics costituiscono sicuramente un ulteriore strumento di indagine a disposizione degli investigatori per poter estrarre ed inferire, utili informazioni dalle immagini (e dai video) digitali. Sono stati anche introdotti alcuni concetti di base, necessari per poter comprendere i dettagli tecnici degli algoritmi presentati, con particolare riferimento alle manipolazioni (o forgery). Per essere in grado di recuperare o far emergere delle evidenze di prova è comunque necessaria una adeguata competenza specifica che richiede uno studio sistematico dei fondamenti della teoria dell’elaborazione delle immagini e dei video digitali. Gli stessi software oggi esistenti, di supporto al lavoro degli investigatori, non riescono per forza di cose ad automatizzare in maniera sistematica ed efficiente tali operazioni e richiedono l’ausilio di utenti esperti [22, 23].

In un prossimo articolo ci si concentrerà sulle potenzialità del settore per l’estrazione di informazioni (targhe, volti, dinamiche) riportando anche una serie di casi di studio di recente attualità.

Sitografia/Bibliografia

[1] M. Pollitt – A history of digital forensics – Advances in Digital Forensics VI pp. 3-15, 2010;

[2] R. Böhme, F.C. Freiling, T. Gloe, M. Kirchner – Multimedia Forensics Is Not Computer Forensics – Proceedings of International Workshop on Computer Forensics, pp. 90-103, 2009;

[3] S. Battiato, O. Giudice, A. Paratore – Multimedia Forensics: discovering the history of multimedia contents – In ACM Proceedings of the 17th International Conference on Computer Systems and Technology, 2016;

[4] S. Battiato, G. Messina, R. Rizzo – Image Forensics – Contraffazione Digitale e Identificazione della Camera di Acquisizione: Status e Prospettive – Chapter in IISFA Memberbook 2009 DIGITAL FORENSICS – Eds. G. Costabile, A. Attanasio – Experta, Italy 2009;

[5] S. Battiato, O. Giudice, A.B Paratore – “Social” Image Forensics: Status e Prospettive – Chapter in IISFA Memberbook 2016 DIGITAL FORENSICS – Eds. G. Costabile, A. Attanasio, M. Ianulardo – Edizioni In Magazine/Menabò Group, Italy 2016;

[6] O. Giudice, A. Paratore, M. Moltisanti, S. Battiato – A Classification Engine for Image Ballistics of Social Data – In Proceedings of International Conference on Image Analysis and Processing (ICIAP) 2017, Springer LNCS, Vol.10485, pp. 625-636;

[7] S. Battiato, G.M. Farinella, G. Puglisi – Image/Video Forensics: Casi di Studio Chapter in IISFA Memberbook (2011);

[8] S. Battiato, A. Catania, F. Galvan, M. Jerian, L.P. Fontana – Acquisizione ed Analisi Forense di Sistemi di Videosorveglianza – Chapter in IISFA Memberbook 2014 DIGITAL FORENSICS – Eds. G. Costabile, A. Attanasio – Experta, Italy 2015;

[9] Hany Farid, Photo Forensics – MIT Press – November 2016;

[10] M.P.J. Ashby – The Value of CCTV Surveillance Cameras as an Investigative Tool: An Empirical Analysis – European Journal on Criminal Policy and Research – pp.1-19, 2017;

[11] https://petapixel.com/2013/05/08/how-photographers-photoshopped-their-pictures-back-in-1946/ , 2017

[12] Cynthia Baron – Adobe PhotoShop Forensics: Sleuths, Truths, and Fauxtography Cengage Learning Ptr (2007);

[13] S. Battiato, F. Galvan, M. Jerian, M. Salcuni – “Linee guida per l’autenticazione forense di immagini”. Chapter in IISFA Memberbook (2013);

[14] S. Battiato, G. Messina. “Digital forgery estimation into DCT domain: a critical analysis.” Proceedings of the First ACM workshop on Multimedia in Forensics. ACM, 2009;

[15] F. Galvan, G. Puglisi, A.R. Bruna, S. Battiato – First Quantization Matrix Estimation from Double Compressed JPEG Images – IEEE Transactions on IEEE Transactions on Information Forensics and Security, Vol. 9, Issue 8, pp. 1299-1310, 2014;

[16] Battiato, S., Mancuso, M., Bosco, A., Guarnera, M. Psychovisual and statistical optimization of quantization tables for DCT compression engines. In IEEE Proceedings of Image Analysis and Processing, 2001, pp.602-606;

[17] www.enfsi.org, 2017;

[18] http://daily.wired.it/news/cultura/2013/05/17/world-pressphoto-34648.html, 2017;

[19] http://www.processig8.org/Udienze%2025/Ud.%20143/143_motivazioni-03_25.html, 2017;

[20] I cacciatori di bufale digitali: «Così staniamo i falsi», CorriereTV, Marzo 2017 http://www.corriere.it/video-articoli/2017/03/01/i-cacciatori-bufale-digitali-cosi-staniamo-falsi/e9a7a9b0-fe9b-11e6-844d-f8ea6c2a643b.shtml

[21] S. Battiato, F. Galvan – Verifica dell’Attendibilità di un Alibi Costituito da Immagini o Video – Sicurezza e Giustizia – Numero II/MMXIV – pp. 47-50 – 2014;

[22] http://ampedsoftware.com/authenticate, 2017;

[23] http://ampedsoftware.com/five , 2017;

A cura di: Prof. Sebastiano Battiato

Sebastiano Battiato è Professore Ordinario di Informatica presso l’Università di Catania. Ha conseguito la Laurea in Scienze dell’Informazione (summa cum laude) nel 1995 e il dottorato di Ricerca in Matematica Applicata ed Informatica nel 1999. Dal 1999 al 2003 ha coordinato e diretto il gruppo di ricerca “Imaging” c/o STMicroelectronics a Catania. Dal 2004 presta servizio presso il Dipartimento di Matematica ed Informatica dell’Università di Catania come ricercatore (fino al 2010) da Professore Associato (fino al Settembre 2016) e da Professore Ordinario in Informatica (dal 1 Ottobre 2016).